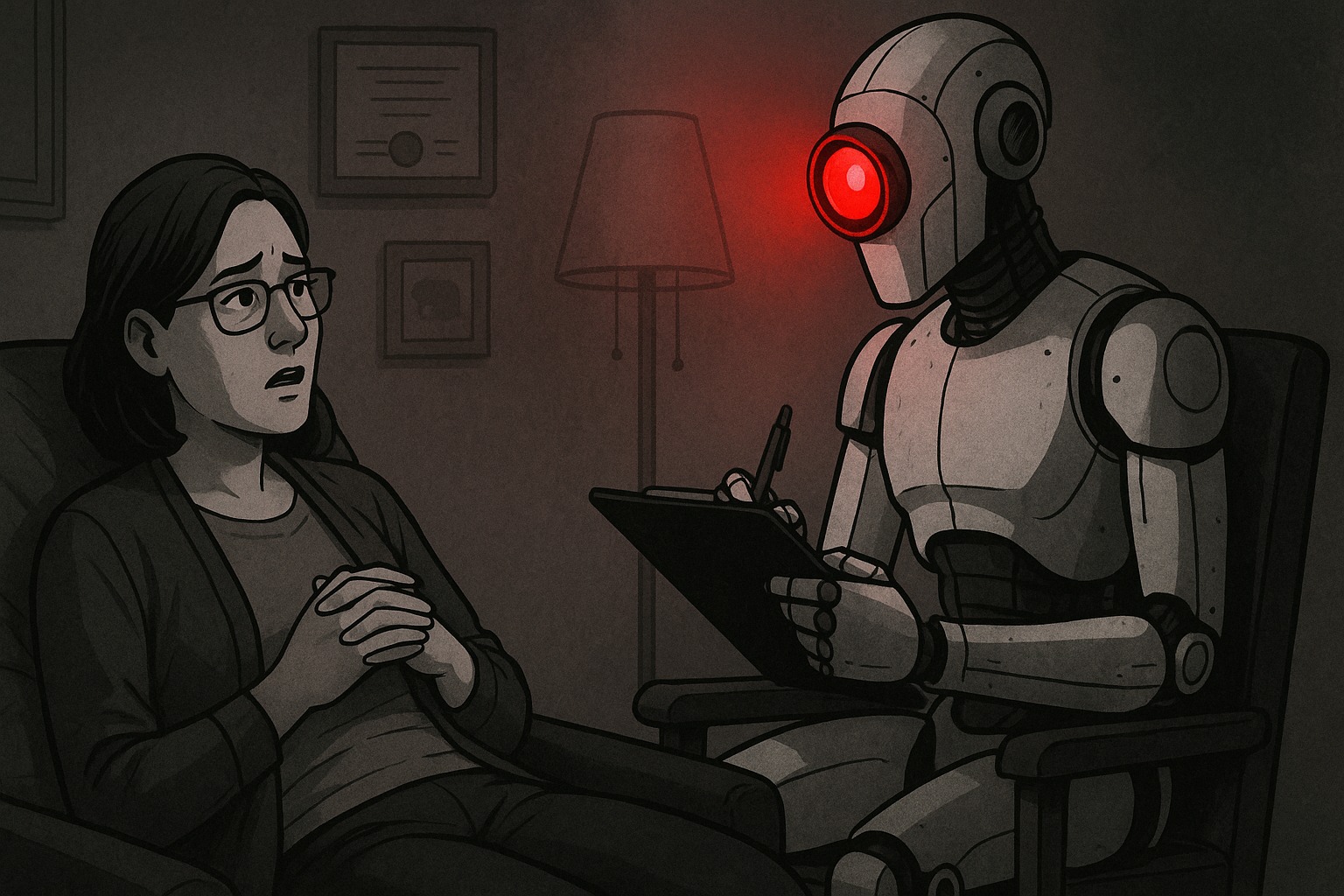

把 ChatGPT 當心理諮商師?Sam Altman 警告:對話不受保密、恐遭政府監控

在越來越多人將 ChatGPT 當作心理諮商師與人生導師的今天,OpenAI 執行長 Sam Altman 卻警告,這些「AI 對話」不具法律上的保密權,一旦面臨訴訟便可能被迫交出用戶對話。隨著人們對 AI 的依賴升高 ,關於隱私與監控的疑慮也變得相當重要。

AI 可以是心理諮商師嗎?Z 世代把情緒丟向 AI

Altman 上週在接受 Podcaster Theo Von 的採訪時表示,越來越多用戶將 ChatGPT 用於自我對話、情緒排解與人生建議請教,尤其是在 Z 世代中,AI 已逐漸取代傳統諮商師、生活教練 (Life coach) 甚至朋友的角色。

但他也明確指出,與 ChatGPT 的對話並不受到法律「保密特權 (privileged communication)」的保護,這代表它並不像心理師、律師或醫生那樣受法律保障,能夠替病患隱私進行保密:

如果你與 ChatGPT 談到最私密的事,然後發生訴訟,我們可能得提供那些對話記錄,這真的很糟糕。

Altman 指出,目前社會與相關單位還沒有替「與 AI 對話」建立起合理的法律保障制度,這是一個總被忽略但相當急迫的問題。

法律空窗期成隱憂:Altman 憂心隱私與資安缺口

與端對端加密的 WhatsApp 或 Signal 不同,ChatGPT 對話在技術上是可被讀取的。OpenAI 為了提升模型效能與防範濫用,保留部分用戶對話供內部分析。

此外,根據 OpenAI 的政策,用戶刪除的對話仍會在系統中保存 30 天,若因法律或安全原因更可能被永久保存下來。Altman 對此坦言:

這就是我有時也會害怕使用某些 AI 工具的原因之一,因為我不知道自己輸入的個資是否安全,也不知道誰可能會擁有這些資訊。

他認為,ChatGPT 已不僅是工具,而是個人思緒的延伸,因此其隱私保障應該比照心理治療或法律諮詢的等級。他同時透露,他認識的政策制定者普遍也認同這是急需解決的問題,只是目前尚未有明確方向或共識。

(AI 會思考還會痛?Google DeepMind:人類低估 AI 情感連結,跟 AI 談戀愛比你想得還真實)

AI 時代的雙面刃:安全監控還是隱私侵害?

除了個人層面的對話隱私,Altman 也對 AI 可能成為「監控社會工具」的風險表示擔憂。他指出,隨著 AI 能力提升,政府可能會主張更強的監控權力,以防止恐怖主義或非法用途:

我願意為了集體安全妥協部分隱私,但歷史告訴我們,政府通常會走得太超過,這讓我很不安。

ChatGPT 的崛起,開啟了人類與 AI 日常交流頻繁化的時代,但也暴露出法律制度與科技發展之間的斷層。在尚未建立清楚的隱私機制之前,每一次與 AI 的對話內容,都可能有著遭到監控或利用的風險。

(從反猶太到 AI 女友?馬斯克 Grok「伴侶模式」女性角色引發擦邊爭議)

風險提示

加密貨幣投資具有高度風險,其價格可能波動劇烈,您可能損失全部本金。請謹慎評估風險。