輝達 GPU、Google TPU 和 AWS 自研 AI 晶片的技術差異

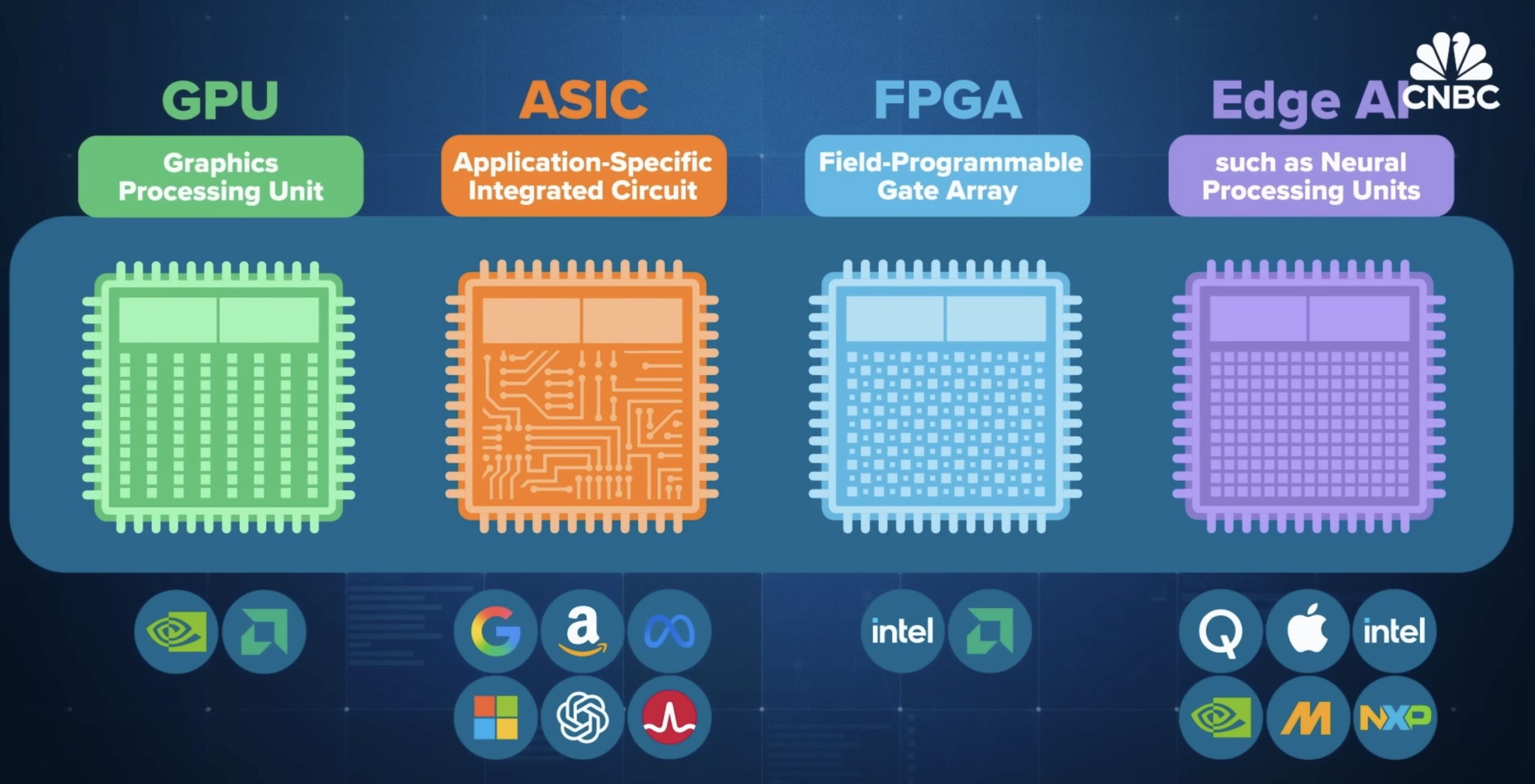

在生成式 AI 席捲全球的當下,驅動這一波革新的核心,是一顆顆高速運算的人工智慧晶片。過去十多年,輝達(NVIDIA)以 GPU 種下 AI 工業革命的種子,如今 Blackwell GPU 專為最先進的 AI 訓練與推理打造,已成為全球資料中心的標準設備,去年出貨量更達 600 萬顆。在大型伺服器機架中,72 顆 GPU 可透過 NVLink 技術彙整為如同單一巨型 GPU 的運算單元。現今,AI 晶片市場已不再是輝達 GPU 獨佔的舞台,客製化 ASIC 、FPGA 正被大型科技企業採用,這些 AI 晶片的差別為何?未來會如何影響到 AI 發展,甚至可能會動搖輝達一家獨大的局面?本文摘自CNBC 影片重點編譯整理。

GPU:AI 黃金時代的開端

GPU 從遊戲卡躍升為 AI 核心,可追溯至 2012 年的 AlexNet。研究團隊首次將輝達 GPU 的平行運算能力用於神經網路訓練,成功在影像辨識競賽中大幅領先其他對手,也開啟深度學習時代。

GPU 的核心優勢來自其數千個並行處理核心,能高效執行矩陣乘法等張量運算,正適合 AI 訓練與推理。現今輝達不僅向 OpenAI、各國政府與企業供應 GPU,也直接打造整套伺服器系統。單一機架的 Blackwell 伺服器售價高達 300 萬美元,輝達甚至透露每週出貨 1000 台,足見 AI 算力需求之狂熱。輝達競爭對手 AMD 則依靠 Instinct GPU 與開源軟體生態系加速進展,近期更獲 OpenAI 與 Oracle 支持,成為 AI 基礎設施市場重要推手,AMD GPU 的區別在主要使用開源軟體,而 Nvidia GPU 則緊密圍繞 CUDA 進行最佳化,CUDA 是 Nvidia 的專有軟體平台。

專門為單一用途而設計的 ASIC 成為新趨勢

從 Google、亞馬遜、Meta、微軟,到 OpenAI 與博通,各大雲端巨頭紛紛投入客製化 ASIC(應用專用積體電路)的研發。這些專為單一用途設計的晶片,在未來幾年預計將成為成長速度最快的 AI 晶片類別。

隨著大型語言模型步入成熟期,推理需求正快速超越訓練。推理的成本、能耗與穩定度成為雲端平台的痛點,而這正是 ASIC 的主戰場,與萬用的 GPU 不同,ASIC 如同一把「專用超精密工具」,針對單一類型 AI 工作負載進行硬編碼最佳化,因此速度更快、功耗更低。缺點是靈活性較差,且開發門檻極高,一顆客製晶片的設計成本動輒數十億美元,因此只有雲端巨頭能負擔。

用於 AI 的客製化 ASIC 成本更高。極其昂貴,至少需要數千甚至數億美元。但對於那些負擔不起客製化 ASIC 的大型雲端服務供應商來說,客製化 AS6 卻能帶來回報因為它們能效更高,而且減少了對輝達的依賴。

博通的 ASIC 強勢挑戰 AI 市占率

博通與 Marvell 等晶片代工設計公司,是超級大型雲端企業的核心戰略夥伴。Google TPU、Meta 自研加速器,以及 OpenAI 即將問世的 ASIC,都由博通深度參與。博通幫助建構 Google 的 TPU 和 Meta 的 AI 推理訓練,分析師預估博通在客製化 ASIC 市場的市占率可達 70 % 至 80 %。

FPGA:介於 ASIC 與 GPU 之間的彈性選擇

FPGA 用於在設備端而非雲端為邊緣 AI 提供支援的晶片。FPGA 最大優勢在「可重新配置」。當企業需要在硬體尚未定案時測試架構時,FPGA 提供介於 GPU 通用性與 ASIC 高效能之間的選項。雖然效能不如 ASIC,但靈活度使其仍受到資料中心與嵌入式設備青睞。AMD(併購 Xilinx)與英特爾(併購 Altera)是 FPGA 市場的兩大主力。

Google TPU

Google 是 ASIC 第一個大玩家,率先打造了用於人工智慧加速的客製化專用積體電路(ASIC),並在其首款 ASIC 於 2015年 問世時創造了 Tensor Processing Unit (張量處理器,TPU)這個專有名詞。TPU 也促成 Google 於 2017 年發明了 Transformer 架構,成為 ChatGPT、Claude 等 AI 的共同基礎。如今 Google 已發展到第 7 代 TPU Ironwood,並協助Anthropic 使用上百萬顆 TPU 訓練 Claude 系列模型。外界盛傳 TPU 在某些情況下甚至超越輝達的 GPU,但 Google 傳統上僅自用,因此 TPU 的真正潛力仍未完全釋放。

AWS Tranium:雲端推理矩陣

AWS 在收購 Annapurna Labs 後,全力投入研發自家 AI 晶片。Tranium 與 Inferentia 已成為 AWS 訓練與推理平台的重要支柱。Tranium 以大量小型張量引擎組成,高度靈活,據 AWS 表示性價比高於雲端中的其他硬體 30 % 至 40 %。2024 年,Anthropic 在 AWS 北印第安納資料中心以 50 萬顆 Tranium 2 訓練模型,其中甚至完全沒有輝達 GPU,可見 ASIC 的地位正在抬頭。

NPU(神經網路處理器):手機、電腦、車用裝置的邊緣 AI 晶片

除了資料中心,AI 晶片也向個人裝置延伸。NPU(神經網路處理器)為專門在裝置上運行邊緣人工智慧而設計的晶片,而不是在雲端運行,可以保障個人隱私。現已整合在高通 Snapdragon、AMD、英特爾與蘋果 M 系列 SoC 中,用於手機、筆電、智慧家庭、汽車甚至機器人。設備端 AI 將帶來更高的隱私保障、更低延遲與更強的控制性,是下一波 AI 普及的重要推力。

台積電成為晶片爭奪戰的核心

無論是輝達 Blackwell、Google TPU 或 AWS Tranium,大多數 AI 晶片最終都由台積電代工。這讓 AI 算力供應與全球地緣政治緊密綁定。美國正試圖透過台積電亞利桑那廠與英特爾 18A 製程,將部分晶片製造能力拉回本土。然而,中國企業如華為、阿里巴巴也正積極打造自家 ASIC,在出口管制下尋求本土替代方案。

AI 晶片群雄時代來臨

無論是輝達 GPU 的強勢霸權,還是 Google、AWS、Meta、OpenAI 等企業的 ASIC 賽道與 NPU 正將邊緣 AI 推往每一台手機與汽車,晶片戰爭仍在加速升溫。雖然要撼動輝達的地位並不容易,但 AI 市場規模巨大,新玩家不斷湧入,未來十年的晶片版圖勢必更加激烈。

風險提示

加密貨幣投資具有高度風險,其價格可能波動劇烈,您可能損失全部本金。請謹慎評估風險。