劍橋研究:2026 年人類資料將被 LLM 學習殆盡,AI 恐因「哈布斯堡現象」崩壞

在生成式 AI 時代,OpenAI、Google、Anthropic 等巨頭的模型幾乎吃盡全網公開資料。但根據牛津大學與多所機構的研究顯示,到 2026 至 2028 年,人類能提供給 AI 的高品質公開資料即將耗盡。當網路被 AI 生成內容淹沒,新模型勢必得用 AI 產生的資料訓練自己。這個自我參照的過程,正如同AI 的近親通婚。

2026 年人類產生的資料,將被 AI 學習殆盡

牛津大學、劍橋大學與多所研究機構於 2024 年 4 月發表的論文 〈The Curse of Recursion: Training on Generated Data Makes Models Forget〉揭露這個現象。

他們發現:當生成式模型反覆使用自己產生的資料進行訓練時,即使在理想條件下,模型也會逐漸遺忘現實,最終陷入退化。研究團隊以語言模型、變分自動編碼器 (VAE) 與高斯混合模型 (GMM) 等多種架構實驗後指出,每一次再訓練都像影印機重印影本:細節逐漸消失,罕見事件最先被遺忘。過幾代後,模型只剩下平均值與主流樣貌,最終變得平庸、單一、甚至錯誤。

此過程就像一場由模型自己發動的資料中毒 (self-poisoning)。最終的結果,是模型不再理解語言與現實,輸出變成重複的胡言亂語。

史丹佛論文:真實資料持續參與,AI 就不會崩壞

然而,2024 年 4 月史丹佛大學與 Constellation 團隊發表的論文 〈Is Model Collapse Inevitable? Breaking the Curse of Recursion by Accumulating Real and Synthetic Data〉,帶來了更樂觀的答案。他們重現了牛津團隊的實驗,但提出新的訓練策略:讓資料累積而非替換。也就是說,新一代 AI 不丟棄舊的人類資料,而是持續疊加、融合人類與 AI 生成的內容。

結果顯示若每次訓練都以新合成資料取代舊資料,模型表現會線性惡化。但若保留原始資料並持續累積,模型誤差會逐漸趨於穩定,甚至停止惡化。他們在語言模型 (GPT-2、Llama 2)、影像生成 (VAE)、以及分子生成 (Diffusion model) 上反覆驗證,皆得到一致結論:只要真實資料仍持續參與,AI 就不會崩壞。

研究者在理論上也證明:當資料累積時,模型誤差的上限是有限的,不會無限膨脹。這意味著 AI 的「近親通婚」不是命中注定,只要我們不切斷與人類真實資料的連結。

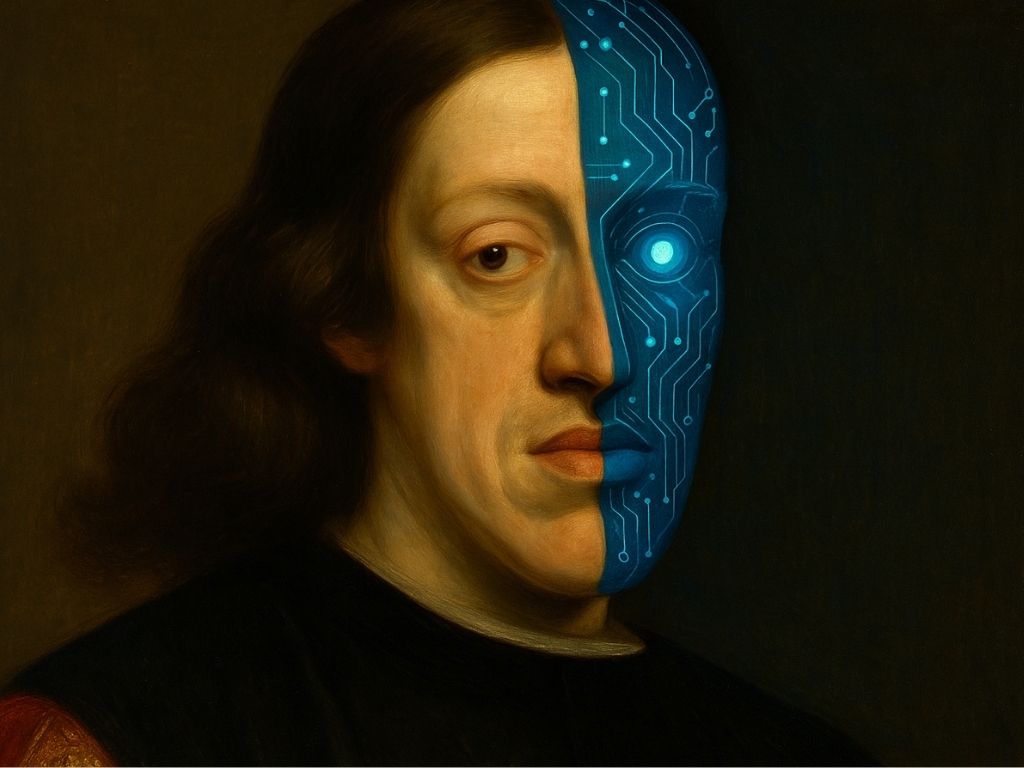

AI 也有哈布斯堡現象,自我參照迴圈如同近親通婚

曾任 Google 軟體工程師的 iKala 創辦人程世嘉,用人類歷史上知名的哈布斯堡家族來形容這一現象。歐洲歷史上知名的哈布斯堡王朝,為了維護血統純正,用近親聯姻的方式將財富、權力鎖在家族內部。結果就是出現知名的「哈布斯堡下巴」,但這只是遺傳問題的冰山一角。各種遺傳疾病、癲癇、智力缺陷甚至高夭折率都是哈布斯堡家族的詛咒,末代國王卡洛斯二世因此身患多種疾病,終身無後。

程世嘉用更具體的案例來解釋,原本是一幅充滿了細節、甚至有小瑕疵的風景畫。畫家風格、細節、筆觸、瑕疵等其實就代表基因多樣性。第一次影印時,AI 生成影本 (合成數據)。這時影本 99.9% 接近原版。但是,AI 是一個模型,它會從中取平均值,平滑處理瑕疵 (代表罕見知識),並稍微強化最常見的特徵 (主流觀點)。下一代從中學習,又取平均值,這就是自我參照迴圈。

風險提示

加密貨幣投資具有高度風險,其價格可能波動劇烈,您可能損失全部本金。請謹慎評估風險。